“Las tecnologías digitales se emplean en el estado de bienestar para vigilar, atacar, acosar y castigar a los beneficiarios, especialmente a los más pobres y vulnerables” indicó el relator para la ONU de los derechos humanos Philip Alston el pasado 18 de octubre en la Asamblea General de la ONU.

Según el relator sobre pobreza extrema, las naciones de todo el mundo están tropezando como zombis en una distopía de bienestar digital en la que la inteligencia artificial y otras tecnologías se utilizan para atacar, vigilar y castigar a las personas más pobres.

En el informe, al que tuvo acceso LadoB, indica que la inteligencia artificial tiene el potencial de mejorar dramáticamente la vida de las comunidades desfavorecidas pero eso se está perdiendo en medio del impulso constante por la reducción de costos y la eficiencia.

Alston denunció la falta de regulación de las empresas del sector privado que operan en una “zona libre de derechos humanos” cercana mientras venden herramientas que transforman la gestión del bienestar, a menudo eliminando el componente humano más importante. Destacó la carga política de muchos esfuerzos aparentemente destinados a aumentar la eficiencia, lo que permite que “las políticas económicas neoliberales [se] mezclen perfectamente con lo que se presentan como reformas de bienestar de vanguardia”.

Peor aún, se diezman los presupuestos de asistencia social y se imponen nuevas sanciones por incumplimiento a las personas que pueden ser analfabetas digitales o no tienen acceso. En el Reino Unido 12 millones de personas, o uno de cada cinco de la población, no tienen las habilidades digitales esenciales necesarias para la vida cotidiana moderna. En India, a causa de que la autenticación biométrica falla, ya hay varios muertos de hambre a causa del bug de Aadhaar.

“Un futuro tecnológicamente impulsado será desastroso si no se guía por el respeto a los derechos humanos”.

¿Y por casa como andamos en bienestar digital?

En Argentina, la situación es similar, como mencionamos en esta nota sobre los “Abuelos digitales” y la digitalización de las recetas electrónicas.

Desde el Observatorio de Derecho Informático Argentino (ODIA) indican la gravedad del hecho, pidieron informes al respecto pero las respuestas, aún, no fueron contundentes.

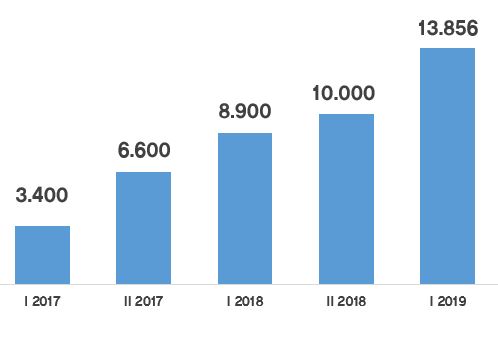

En la Ciudad de Buenos Aires, hay 13.856 cámaras distribuidas en la ciudad: en colectivos (69%), vía pública (18%) y subte (13%). El Sistema de Reconocimiento Facial de Prófugos (SRFP) trabaja junto con el de Consulta Nacional de Rebeldías y Capturas (CONARC) y funciona con 300 de las cámaras. Lo hace a través de un software ruso licitado a principios de este año. Horacio Rodriguez Larreta, actual jefe de Gobierno de la Ciudad, indicó que planea ampliar este número a 10.000.

A partir de casos erróneos, la base de datos del CoNaRC que en abril contenía a 45 mil personas actualmente se redujo a 24 mil personas registradas en el sistema, casi la mitad. ¿Cómo le fue? De las 1631 personas identificadas desde la implementación del software, sólo 329 quedaron detenidas. Las otras 1302 fueron demoradas y puestas en libertad. Es decir, un 20% de acierto, un 80% de error.

En Córdoba, la policía acaba de poner en funcionamiento un camión con cámaras que permite identificar prófugos o buscados, en la vía pública o eventos. El plan del Gobierno cordobés se complementa con un sistema de cinco puestos que cuentan con cuatro cámaras fijas, cada uno. Cada cámara apunta hacia un punto cardinal. Estos puestos están ubicados en sitios de alto movimiento en la ciudad de Córdoba y sus señales son emitidas a Jefatura. Esto es posible gracias a la Ley 9380.

En ninguno de los casos de realizó una evaluación de impacto de la privacidad ni se legisló detalladamente. Según detalla en su informe Joseph Cannataci, Relator Especial sobre el derecho a la privacidad de la ONU: “Me preocupa que ni Buenos Aires ni Comodoro Rivadavia hayan realizado ninguna evaluación de impacto en la privacidad antes de implementar amplias redes de cámaras de vigilancia o sistemas de reconocimiento facial y reconocimiento de matrículas. Los funcionarios y funcionarias a los que entrevisté dijeron que estaban seguros de que el derecho a la privacidad no estaba siendo violado por los sistemas existentes y que cumplían los requisitos legales, pero que no podían explicar su necesidad y proporcionalidad. En estos y otros casos similares es esencial que las evaluaciones preliminares de impacto se lleven a cabo inmediatamente y sin demora y que sus recomendaciones sobre salvaguardias y recursos se cumplan de inmediato”.

La tasa de error de los sistemas biométricos es, en condiciones óptimas, superior al 30%. En escenarios reales puede ser exponencialmente mayor. Como indica esta nota de The Independent en software de reconocimiento facial utilizado por la Policía Metropolitana de Reino Unido proporcionó más de un 98% de falsos positivos en las alertas generadas.

¿Por qué pobres digitales? Porque la tecnología no se aplica a favor de ellos ni pensando en las minorías desconectadas. Son cartas políticas en pos de mayor seguridad, sin respetar las cadenas de custodia de la información, la legislación y la opinión de los expertos.

En mi columna semanal en Pasaron Cosas, Radio con Vos, hablamos al respecto.

Si querés recomendar el blog, comentar o apoyarlo, podes escribirme a info@ladob.net